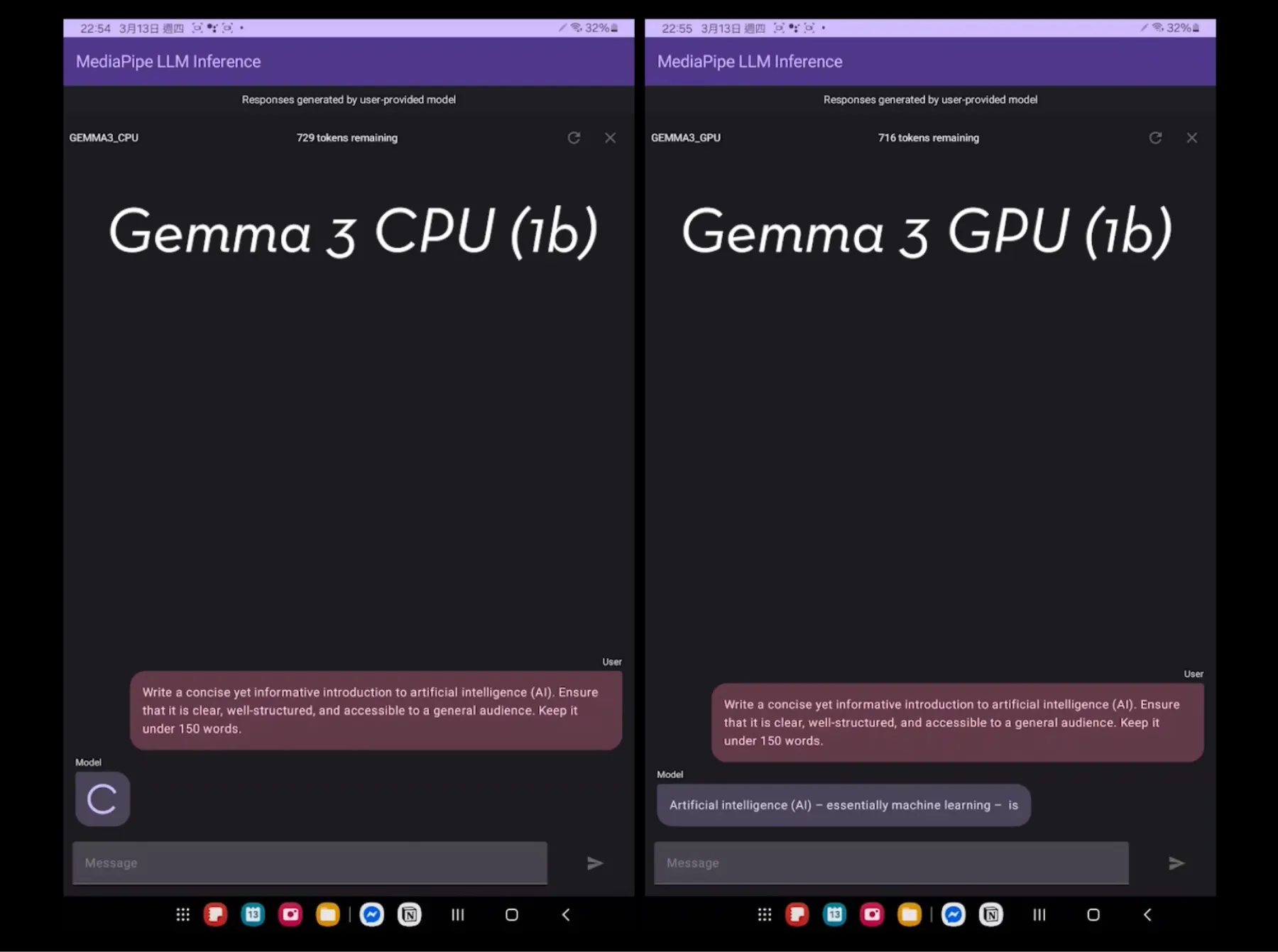

我最近在 Samsung Tab S9 上做了一個簡單的測試,想看看在行動裝置上直接跑本地 AI 推論是否實用,特別是針對 Gemma 3 的性能改進。我依照 Google 官方的 MediaPipe LLM inference 指南完成設定。

測試環境#

- 裝置: Samsung Tab S9(8GB RAM,Snapdragon® 8 Gen 2)

- 環境: MediaPipe LLM Inference

- 模型:

- Gemma 3 (1B) CPU 與 GPU

- PHI-4-mini-instruct (CPU)

- DeepSeek-R1-Distill-Qwen-1.5B (CPU)

性能測試結果#

Tokens Per Second#

- Gemma 3 GPU:52.4 tokens/sec

- Gemma 3 CPU:42.8 tokens/sec

- DeepSeek-R1 CPU:15.7 tokens/sec

- PHI-4-mini CPU:4.5 tokens/sec

生成 150 字提示詞所需時間#

- Gemma 3 GPU:3.3 秒

- Gemma 3 CPU:5.4 秒

- DeepSeek-R1 CPU:34.3 秒

- PHI-4-mini CPU:45.8 秒

推理測驗:「All but Three」#

為了簡單測試邏輯推理,我問了模型:

解答下列問題並逐步說明推理過程:某農夫有 10 隻羊。除了三隻以外全部跑掉了,他還剩下幾隻羊?

正確答案是 3,但令人意外地,所有模型都回答錯:

- Gemma 3(CPU 與 GPU):回答 7

- PHI-4-mini 與 DeepSeek-R1:回答 7

雖然這些都是小模型,但看到它們在這麼簡單的語意題上仍出錯,還是讓人覺得有點好笑。

結語#

這次測試顯示在行動裝置上進行本地 AI 推論相當可行,尤其是搭配 GPU 的 Gemma 3 表現令人驚艷。不過也再次提醒我們,小模型在處理細微的邏輯推理時仍有明顯限制。